Apple annuncia in anteprime alcune nuove funzioni di accessibilità di iOS 18: Eye Tracking, Music Haptics e Vocal Shortcuts

Arriveranno entro la fine dell’anno, ma Apple le ha svelate in anteprime. Sono le nuove funzioni di accessibilità, tra cui cui l’Eye Tracking che permette a utenti con disabilità fisiche di controllare iPad o iPhone usando soltanto gli occhi. A queste si aggiunge il Music Haptics, che permette a persone sorde o ipoudenti di “sentire” la musica usando il Taptic Engine su iPhone. E infine il Vocal Shortcuts, che consente all’utente di eseguire attività riproducendo un suono personalizzato. Il Vehicle Motion Cues riduce la chinetosi quando si usa iPhone o iPad all’interno di un veicolo in movimento; e altre funzioni di accessibilità che arriveranno con visionOS. Queste funzioni sfruttano in combinazione il chip Apple, l’intelligenza artificiale e il machine learning on-device.

“Crediamo fermamente nel potere trasformativo che le innovazioni hanno nel migliorare la vita delle persone – ha detto Tim Cook, CEO di Apple – È questo il motivo per cui Apple, da circa 40 anni, promuove il design inclusivo integrando l’accessibilità fin nelle fondamenta del nostro hardware e software. Ridefiniamo continuamente i confini di ciò che la tecnologia riesce a fare, e queste nuove funzioni riflettono il nostro impegno costante nell’offrire la migliore esperienza possibile a ogni persona”.

“Ogni anno sperimentiamo qualcosa di completamente nuovo nel campo dell’accessibilità – ha detto Sarah Herrlinger, Senior Director of Global Accessibility Policy and Initiatives di Apple -. Queste nuove funzioni avranno un impatto importante nella vita di un vasto gruppo di utenti, aprendo la strada a nuovi modi di comunicare, controllare i dispositivi ed esplorare il mondo”.

Eye Tracking arriva su iPad e iPhone

La funzione Eye Tracking, basata sull’intelligenza artificiale, sarà inclusa di serie e permetterà di controllare iPad e iPhone usando soltanto gli occhi. È stata sviluppata pensando a chi ha una disabilità fisica, e usa la fotocamera frontale per completare in pochi secondi la configurazione e la calibrazione. Inoltre, grazie al machine learning on-device, tutti i dati utilizzati per configurare e controllare questa funzione restano al sicuro sul dispositivo e non vengono condivisi con Apple.

Eye Tracking è compatibile con le app iPadOS e iOS, e non richiede hardware o accessori extra. Grazie a Eye Tracking, l’utente può spostarsi fra gli elementi di un’app e usare la funzione Controllo con ritardo per attivare ciascun elemento, accedere a funzioni aggiuntive come pulsanti fisici, usare lo scorrimento o altri gesti, il tutto soltanto con gli occhi.

Con Music Haptics la musica diventa più accessibile

Music Haptics permette alle persone sorde o ipoudenti di “sentire” la musica su iPhone in un modo completamente inedito. Quando questa funzione è attivata, il Taptic Engine di iPhone riproduce colpi, texture sonore e le vibrazioni sottili di una canzone. È compatibile con milioni di brani del catalogo Apple Music e sarà disponibile come API, così chi sviluppa potrà rendere la musica più accessibile nelle proprie app.

Nuovi funzioni per una vasta tipologia di voci

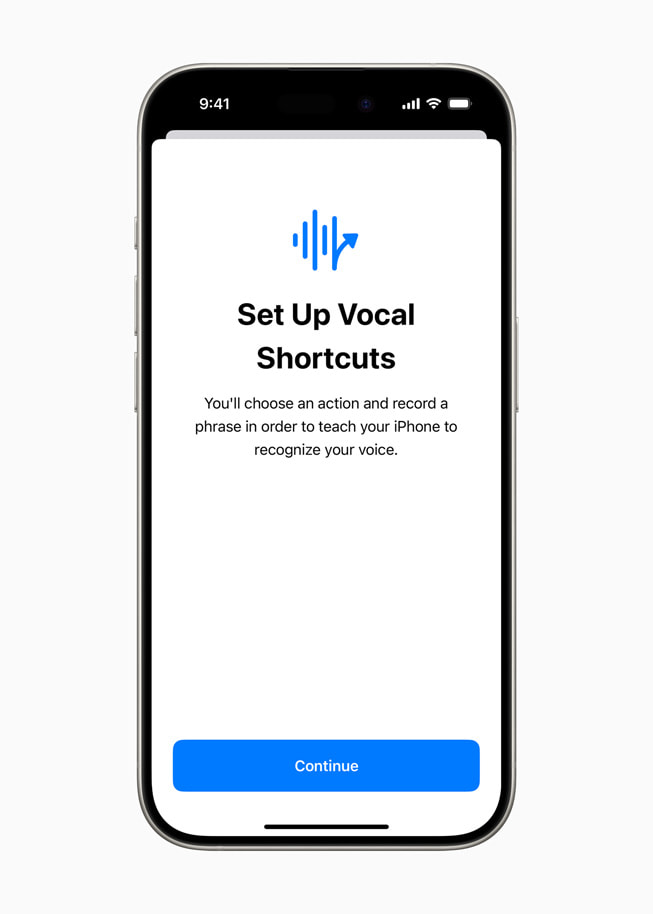

La funzione “Vocal Shortcuts” permette a chi usa iPhone e iPad di assegnare ai comandi frasi personalizzate, che Siri è in grado di comprendere, per attivare scorciatoie e completare task complessi. Un’altra novità è la funzione “Listen for Atypical Speech”, che offre all’utente la possibilità di migliorare il riconoscimento vocale per un più ampio range di voci, avvalendosi del machine learning on-device per riconoscere gli schemi vocali. Sviluppate pensando alle persone con condizioni acquisite o progressive che compromettono la capacità di parlare, come paralisi cerebrale, sclerosi laterale amiotrofica (SLA) o ictus, queste funzioni offrono un nuovo livello di personalizzazione e controllo. Sono sviluppate a partire dalle funzioni introdotte già con iOS 17 per utenti che non parlano o rischiano di perdere la capacità di parlare.

“L’intelligenza artificiale ha il potere di migliorare il riconoscimento vocale di milioni di persone che hanno un linguaggio atipico: siamo davvero felici che Apple stia mettendo a disposizione queste funzioni – ha detto Mark Hasegawa-Johnson, ricercatore principale dello Speech Accessibility Project presso il Beckman Institute for Advanced Science and Technology della University of Illinois Urbana-Champaign -. Lo Speech Accessibility Project è nato come un’iniziativa su ampia base supportata dalla comunità per aiutare società e università a rendere il riconoscimento vocale più affidabile ed efficace. Apple è tra le aziende che si battono per l’accessibilità e hanno reso possibile questo progetto”.

Vehicle Motion Cues può contribuire a ridurre la chinetosi

Vehicle Motion Cues è una nuova esperienza per iPhone e iPad che può contribuire a ridurre la sensazione di malessere causata dal movimento del veicolo con cui si viaggia, un disturbo noto anche come chinetosi. Alcuni studi dimostrano che la chinetosi è in genere causata da un conflitto sensoriale fra ciò che si vede e la sensazione che si prova, e questo disturbo potrebbe impedire ad alcune persone di usare iPhone o iPad mentre viaggiano a bordo di un veicolo. Quando si attiva la modalità Vehicle Motion Cues, compaiono dei punti animati ai bordi dello schermo che riproducono le variazioni di movimento del veicolo, in modo da ridurre il conflitto sensoriale senza interferire con il contenuto principale. Grazie ai sensori integrati in iPhone e iPad, Vehicle Motion Cues rileva quando l’utente si trova all’interno di un veicolo in movimento e reagisce di conseguenza. È possibile impostare questa funzione in modo che si attivi in automatico, oppure abilitarla o disabilitarla manualmente in Centro di Controllo.

Controllo vocale arriva su CarPlay, insieme ad altri aggiornamenti per l’accessibilità

CarPlay ora include funzioni di accessibilità, fra cui Controllo vocale, Filtri colore e Riconoscimento suoni. Controllo vocale permette di usare CarPlay e di gestire le app usando soltanto la voce. Con Riconoscimento suoni, le persone sorde o ipoudenti che guidano o viaggiano in auto possono attivare le notifiche per suoni come clacson e sirene. I Filtri colore aiutano le persone affette da daltonismo a visualizzare meglio l’interfaccia di CarPlay; sono disponibili anche altre funzioni assistive per la vista come Testo in grassetto e Testo grande.

Funzioni di accessibilità in arrivo su visionOS

Quest’anno, fra le funzioni di accessibilità che verranno aggiunte a visionOS ci sarà Trascrizioni live, che sarà disponibile a livello di sistema e aiuterà qualsiasi utente, comprese le persone sorde o ipoudenti, a seguire una conversazione dal vivo o i contenuti audio delle app. Grazie alla possibilità di usare Trascrizioni live con FaceTime in visionOS, ancora più persone potranno comunicare e collaborare usando il proprio avatar. Su Apple Vision Pro sarà possibile spostare i sottotitoli usando la barra della finestra durante gli Apple Immersive Video, e verrà aggiunto il supporto per gli apparecchi acustici Made for iPhone e i processori acustici degli impianti cocleari. Per migliorare l’esperienza di chi ha difficoltà visive o preferisce evitare luci troppo accese e lampeggiamenti, verranno aggiunte le funzioni di accessibilità Riduci trasparenza, Inversione smart e Attenua luci lampeggianti.

Queste funzioni vanno ad aggiungersi ad altre decine di funzioni di accessibilità già disponibili su Apple Vision Pro, un dispositivo con un sistema di input flessibile e un’interfaccia intuitiva, progettato tenendo conto di tante diverse tipologie di utente. Funzioni come VoiceOver, Zoom e Filtri colore permetteranno inoltre alle persone cieche o ipovedenti di accedere all’esperienza dello spatial computing, mentre funzioni come Accesso guidato supporteranno chi ha disabilità cognitive. L’utente potrà controllare Vision Pro usando gli occhi, le mani o la voce, nella combinazione che preferisce, insieme a funzioni di accessibilità come Controllo interruttori, Azioni suoni e Controllo con ritardo, utili anche per chi ha disabilità di tipo fisico.

“Apple Vision Pro è senza dubbio la tecnologia più accessibile che io abbia mai usato” ha detto Ryan Hudson-Peralta, cofondatore di Equal Accessibility LLC, product designer e consulente di accessibilità di Detroit. “Essendo nato senza mani e non essendo in grado di camminare, sapevo che il mondo non era fatto su misura per me, ed è stato incredibile vedere che visionOS funziona davvero. Dimostra le potenzialità e l’importanza di avere un design inclusivo e accessibile.”